网站robots协议详解

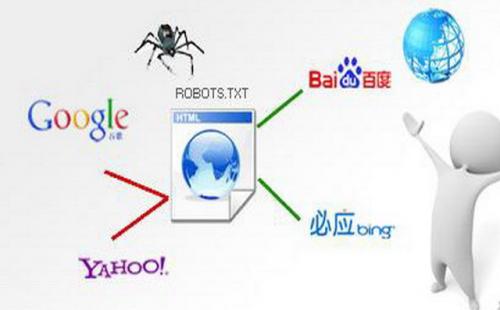

Robots协议全称”网络爬虫排除标准”(Robots Exclusion Protocol),又简称”爬虫协议”,用于告诉搜索引擎网站哪些网页可以抓取,哪些不可以抓取

Robots协议是一个行业公认的规范,几乎所有的搜索引擎都遵守这一标准,但也一些个案,不遵爱robots协议,比如:在12年前,美国加州北部的联邦地方法院就在著名的eBayVS. Bidder's Edge案中(NO.C-99-21200RMW,2000 U.S Dist. LEXI 7282),引用robots协议对案件进行裁定。 Bidder's Edge(简称BE)成立于1997年,是专门提供拍卖信息的聚合网站。12年前,BE利用“蜘蛛”抓取来自eBay等各个大型拍卖网站的商品信息,放在自己的网站上供用户浏览,并获得可观的网站流量。(引用百度百科)

2012年8月,360综合搜索被指违反robots协议:

360甘冒行业道德风险 撕毁Robots自律协议2012年8月29日,上线不到十日即轻松登上国内第二大搜索引擎宝座的奇虎360搜索遭遇滑铁卢,在百度一项打击违规抓取和匿名访问的措施上线后,360搜索通过山寨加绑架用户的模式被彻底揭穿,这个故事也正是对所谓“搜索引擎技术无用论”的当头棒喝。(引用百度百科)

Robots协义的使用

1:禁止所有搜索引擎对网站进行一个抓取

User-agent: *

Disallow: /

2:允许所有搜索引擎对整个网站进行一个抓取或者直接不设置robots协议文件则代表允许所有搜索引擎对网站进行一个抓取

User-agent: *

Allow: /

3:不允百度对网站进行一个抓取

User-agent:Baiduspider

Disallow: /

4:只允许百度对网站进行一个抓取

User-agent:Baiduspider

allow: /

User-agent:*

Disallow: /

5:禁止所有蛛蛛抓取某个特定的目录a和b

User-agent:*

Disallow: /a/

Disallow: /b/

6: 禁止访问所有以某个后缀结束的文件(.htm)

User-agent:*

Disallow: /*.htm$

对于一个seo或者网站运营人员来说,我个人觉得还是有必要了掌握一些简单的robots协议的使用技巧,不要哪天把蛛蛛给禁止抓取了都不知道就尴尬了